L’idée que les émissions de CO2 dues à la combustion de combustibles fossiles (charbon, pétrole, gaz, lignite…) contribuent à augmenter les températures terrestres est due au Suédois Svante Arrhenius, prix Nobel de chimie 1903. Dans son livre majeur1, il affirma que le CO2 fait monter les températures par effet de serre, et ne vit que des avantages, tant à l’élévation des taux atmosphériques de CO2, qu’à l’augmentation des températures. Les thèses d’Arrhenius, longtemps restées dans l’oubli, ont été reprises dans les années 50 par l’océanographe américain Roger Revelle2. Ce dernier montra en 1957 que l’essentiel du CO2 d’origine anthropique (dû à l’activité humaine) était absorbé par les océans, et n’influait qu’à la marge au réchauffent planétaire. Il émit la conjecture que le taux de CO2 atmosphérique pourrait basculer vers une augmentation soudaine, propre à faire monter les températures, si la consommation industrielle de combustibles fossiles croissait brutalement, au point de ne plus être compensée par l’absorption océanique. Revelle continua à soutenir la thèse d’un réchauffement climatique dû aux émissions industrielles de CO2, en convertissant à ses idées le futur vice-président des États-Unis Al Gore, qui fut son élève à l’université d’Harvard de 1967 à 1969. Les idées de Revelle restèrent lettre morte du fait que, contrairement à ses prédictions, l’évolution des températures de 1950 à 1975 fut orientée à la baisse3. La présence d’aérosols d’origine volcanique dans l’atmosphère a, peut-être, compensé l’influence des émissions de CO2, et ce, durant un quart de siècle. Jusqu’en 1987, la croyance majoritaire des scientifiques était que le monde se dirigeait vers une nouvelle glaciation. C’est ainsi qu’en 1983, le climatologue britannique Hubert Lamb4, dans la première édition de son livre sur le climat, prévoyait une baisse annuelle des températures de -0,15 °C, jusqu’en 2015. Si cette prédiction s’était avérée exacte, de 1983 à 2023, on aurait observé en 40 ans une baisse des températures colossale5 de -6 °C (de -4,8 °C en se limitant à l’horizon de 2015). La perspective du nouvel âge glaciaire qui en aurait découlé ne pouvait qu’affoler les experts américains, qui ont mis en place plusieurs groupes de travail gouvernementaux6 destinés à étudier ces questions.

C’est ainsi que, de manière paradoxale, l’intérêt des autorités américaines pour le réchauffement climatique fut issu de la crainte d’un refroidissement majeur (qui ne s’est jamais produit, heureusement).

Dès 1987, plusieurs commissions d’étude sur le climat étaient opérationnelles aux États-Unis, dont le Goddard Institute de la NASA. On consultera à ce sujet les commentaires historiques du Ch.4 du livre d’Olivier Postel Vinay7, et ceux du Ch.2 du livre de 2021 de Christian Gérondeau8.

Le point de bascule dans l’opinion américaine eut lieu en 1988 où les États-Unis connurent la pire sécheresse caniculaire observée depuis le « Dust Bowl » de 1930. Aux USA, l’été 1988 fut torride, avec un pic de chaleur le 25 juin coïncidant avec l’audition par le Congrès des États-Unis du climatologue en chef de la NASA (National Aeronautics and Space Administration), James Hansen. Ce dernier dirigeait, depuis 1981, le Goddard Institute for Space Studies [GISS], au sein de la NASA. Hansen avait une formation d’astronome, et avait émis la thèse que les températures très élevées (460 °C) de la planète Vénus étaient dues entièrement aux fortes concentrations de CO2 présentes dans son atmosphère (il y a 250.000 fois plus de CO2 dans l’atmosphère de Vénus que sur la Terre). Il s’imaginait que l’augmentation des taux de CO2 dans l’atmosphère terrestre pourrait aboutir, comme pour Vénus, et toutes proportions gardées, à des températures excessives. En juin 1988, alors que les climatiseurs n’arrivaient pas à réguler la température dans la salle de réunion du Congrès des États-Unis, Hansen n’eut pas de peine à convertir ses auditeurs aux thèses de Revelle, à savoir de l’existence d’un réchauffement climatique brutal dû aux émissions industrielles de CO2. Notons qu’aucune canicule ne fut constatée en Europe durant cette période, et que ces événements météorologiques extrêmes furent limités au continent américain. Hansen avait perdu toute prudence scientifique, en affirmant, notamment, devant les membres du Congrès "qu’il était certain à 99 % sur la base des 2000 stations d’enregistrement dans le monde, que les gaz à effet de serre, et notamment le CO2, étaient à l’origine du réchauffement". Le fait qu’il est impossible de prouver comme de réfuter de telles assertions atteste clairement du caractère dogmatique de la "religion du climat". Celle-ci sévit depuis l’origine comme l’une des plus grandes erreurs que l’humanité ait connues, avec des conséquences incalculables.

La machine était en marche. Elle avait été préparée en 1985 par la Conférence de Villach (Suisse), sous l’égide de l’Organisation Météorologique Mondiale [OMM] et du département de l’environnement des Nations Unies [PNUE-UNEP] dont le but affiché était d’« étudier le rôle du CO2 et des autres gaz à effet de serre sur les variations du climat ». Les organisations mondiales étaient alors influencées par des personnalités comme le météorologiste suédois Bert Bolin et l’homme d’affaires canadien Maurice Strong. Bert Bolin fut l’animateur principal de la Conférence de Villach qui prédit9 une élévation probable de la température de 4,5 °C dans la première moitié du XXIe siècle, assortie à d’une élévation des océans de 1,5 m. Elle conclut à l’urgence de "mettre en œuvre une politique internationale de réduction des émissions de gaz à effet de serre destinée à minimiser les changements climatiques et la montée des eaux marines". Maurice Strong, quant à lui, était un autodidacte complet, ayant arrêté ses études à 14 ans et fait fortune dans l’industrie pétrolière. Partisan d’un gouvernement mondial, proche de David Rockefeller de la Commission Trilatérale, du Groupe de Bilderberg et du Club de Rome, il se trouva à 44 ans mis à la tête du Programme des Nations Unies pour l’Environnement (United Nations Environment Program) [PNUE-UNEP], qu’il quitta en 1983 pour diriger la Commission Mondiale sur l’Environnement et le Développement, mieux connue sous le nom de « Commission Brundtland10 », dans laquelle il retrouva Bert Bolin. Le 30 mars 1987, sous l’influence de Maurice Strong, était publié le « Rapport Brundtland » qui affirmait, sans preuve, que « le recours aux combustibles fossiles pourrait, dès le début du XXIe siècle, avoir suffisamment augmenté la température moyenne de la planète pour bouleverser les zones de production agricole, inonder les villes côtières du fait de l’élévation du niveau de la mer, et mettre à mal les économies nationales ». Le rapport Brundtland affirmait, de surcroît, « qu’une action internationale vigoureuse était nécessaire pour réduire les volumes de CO2 émis par l’usage des combustibles fossiles ».

Comme on peut le constater par ces faits, dès 1988, s’est installée une « religion du climat », basée sur des prévisions alarmistes invérifiables :

- la température allait monter de +4 °C à +6 °C d’ici 2100 (un horizon suffisamment lointain pour rendre cette prévision invérifiable) ;

- le niveau de la mer allait monter de plusieurs mètres d’ici 2100 ;

- l’ensemble de ces événements serait provoqué par le rejet dans l’atmosphère de CO2 issu de la combustion des « combustibles fossiles ».

Force est de constater que les organismes internationaux au sein de l’ONU n’ont fait que répéter sans preuve les affirmations (1-2-3) qui ont été à chaque fois démenties par les observations.

Nous ne parlerons pas ici des mécanismes naturels (indépendants des rejets anthropiques de CO2) responsables de l’évolution du climat. On peut citer, parmi ceux-ci, les cycles d’activité solaire, comme les cycles de Milankovitč, qui expliquent (en partie) les variations du climat par les variations périodiques de l’excentricité, de l’inclinaison et de la précession de l’orbite terrestre autour du soleil11. D’autres facteurs sont le cycle de Schwab (d’une durée de 11 ans), et les cycles séculaires de Gleissberg. On notera que le petit âge glaciaire s’est produit pendant l’occurrence du grand minimum de Maunder (de 1645 à 1715) durant lequel l’activité solaire fut réduite, avec peu de taches solaires présentes. L’ensemble de ces mécanismes naturels, en association avec les rejets dans l’atmosphère de cendres volcaniques et de SO2 créant des aérosols diminuant l’ensoleillement (et faisant baisser les températures) font paraître les thèses du GIEC comme un salmigondis primitif.

Il est parfaitement clair que le fait de prendre comme seule cause des variations climatiques les rejets anthropiques de CO2 est manifestement contraire à la vérité. Parmi les livres majeurs décrivant les mécanismes naturels de l’évolution du climat, il faut citer, tout particulièrement, l’ouvrage best-seller de Fred, S. Singer et Dennis T. Avery, qui s’est vendu à des centaines de milliers d’exemplaires, depuis sa publication en 2007. Son titre se passe de commentaires : « Unstoppable global warming every 1500 years », Rowman & Litltlefield Publishers, New York.

Ceci étant, le fondement de la « religion du climat » évoquée plus haut, a abouti, en novembre 1988 à la naissance du GIEC-IPCC12, dirigé, durant les 9 années suivantes par Bert Bolin, qui proclama sans réserve le dogme officiel attribuant le réchauffement climatique à l’activité humaine par le biais de rejets de « gaz à effet de serre » (principalement de CO2). L’historique de cette construction administrative est décortiqué dans les livres de Jean-Michel Bélouve13 et Christian Gérondeau (2021)14. Officiellement, le GIEC fut créé à la demande du G7/815 réuni du 19 au 21 juin 1988 à Toronto (Canada). La déclaration économique ayant suivi cette rencontre a requis la « création d’une commission intergouvernementale sur les changements climatiques mondiaux, placée sous les auspices du Programme des Nations Unies sur l’Environnement et de l’Office Mondial de Météorologie ». Les artisans politiques de la création du GIEC au sein du G7/8 furent Ronald Reagan, président des Etats Unis, agissant dans la lignée du Rapport Hansen présenté en juin 1988 devant le Congrès des Etats Unis, et Margaret Thatcher, premier ministre de la Grande Bretagne. Cette dernière menait alors une guerre totale contre l’exploitation du carbone fossile, et plus spécifiquement contre les syndicats de mineurs de charbon. Cette lutte fut émaillée par la grande grève des mineurs de 1984-85 et le démantèlement des mines anglaises qui s’en suivit. Aux côtés de Ronald Reagan, Mme Thatcher a orienté le développement initial du GIEC vers la recherche de la culpabilité du carbone dans l’évolution du climat. Or, comme nous le verrons plus loin, celle-ci est toute relative16. Par la volonté de Ronald Reagan et de Margaret Thatcher, le GIEC n’est donc pas un organisme à dominance scientifique. Il est contrôlé par les représentants des états, et ses avis demeurent dépendants des gouvernements qui le subventionnent.

Peu après la fondation du GIEC, l’Organisation des Nations Unies créa un organisme officiel associé au GIEC, la CCNUCC (Convention Cadre des Nations Unies sur les Changements Climatiques). Cet organisme réunit chaque année depuis 1995 les représentants des états (193 en 2022) composant les Nations Unies dans des « COP » (Conference of Parties) destinées à encadrer les engagements des états sur le changement climatique. Le GIEC lui-même publie des rapports d’évaluation (Assessment Report [AR]). Les premiers de ceux-ci furent publiés en 1990 (AR1, complété en 1992), 1995 (AR2, révisé en 1998) et 2001 (AR3). Les quatrième, cinquième et sixième rapports d’évaluation furent publiés, respectivement en 2007 (AR4), 2013-2014 (AR5), et 2021-2022 (AR6). À ces rapports généraux s’ajoutent des rapports spéciaux [SR]. Le dernier de ceux-ci, le SR15, publié en 2019, a été approuvé en 2018 par les 193 gouvernements composant l’ONU. Il comprend plusieurs affirmations sans preuve, dont nous reprenons les principales. Il envisage deux horizons pour une élévation de température de +1,5 °C ou +2 °C en 2100, par rapport à la période de référence (dite préindustrielle) de 1850-1900. Le rapport SR15 estime que le réchauffement observé jusqu’en 2016 a été de +0,87 °C ≈ +0,9 °C. Une simple soustraction montre que les deux hypothèses du GIEC correspondent à des élévations de température, respectivement, de 0,6 °C et 1,1 °C, en 2100 par rapport à 2023. Dans le 1er cas, il prévoit une élévation du niveau des océans en 2100 comprise entre 26 et 77 cm. Dans le 2e cas, cette élévation serait comprise entre 36 cm et 87 cm. Ces chiffres paraissent démesurément pessimistes. Dans l’hypothèse maximaliste, retenue par S. E. Koonin17, d’une montée du niveau des océans de 3 mm par an, en l’absence de toute limitation des émissions anthropiques de CO2, le niveau de la mer par rapport à 2023 ne monterait de pas plus que de 24 cm en 2100.

Pour ce qui est des températures, la situation est plus complexe. L’évolution dépend de modèles mathématiques, et les rapports du GIEC font référence à quelques dizaines de modèles, comparés entre eux par des évaluations croisées dénotées CMIP (Coupled Models Intercomparison Project). Le CMIP4 (resp. CMIP5, CMIP6) comparait entre eux les modèles du rapport AR4 (resp. AR5, AR6) du GIEC. Ces comparaisons font apparaître des divergences accablantes. Alors que les modèles d’évolution des températures sont censés décrire et expliquer le réchauffement observé au XXe siècle, ils divergent mutuellement d’environ 3 °C, soit trois fois la valeur du réchauffement observé. De ce fait, les modèles pris en compte par le GIEC pour décrire l’évolution des températures jusqu’en 2100 n’ont aucune crédibilité.

Nous citons ici la p.125 du Ch.4 du livre de S. Koonin18 :

« Nous n’avons pas la moindre idée de ce qui provoque l’échec des modèles, incapables de nous dire pourquoi le climat a changé pendant des décennies. C’est profondément troublant, car le réchauffement observé au début du XXe siècle est comparable à celui que nous avons observé à la fin du XXe siècle, réchauffent que les rapports d’évaluation du GIEC attribuent avec une “confiance élevée” aux influences humaines ».

Nous pouvons conclure ici, en premier lieu, que les prévisions d’élévation de température en 2050 ou 2100 du GIEC n’ont aucun caractère de certitude, et en deuxième lieu, que l’attribution de leur origine à l’élévation du CO2 anthropique est infondée. De ce fait, la recommandation du GIEC de réduire à zéro (la neutralité carbone) les émanations anthropiques de CO2 en 2050 pour limiter l’accroissement des températures en 2100 à +1.5°C est du « grand n’importe quoi ». C’est une affirmation gratuite qu’il n’est pas possible, en l’état actuel des connaissances, de confirmer ni d’infirmer. Le problème est que de nombreux gouvernements (comme ceux de l’Union Européenne) ont pris à la lettre ces recommandations, au prix d’un véritable suicide économique et industriel.

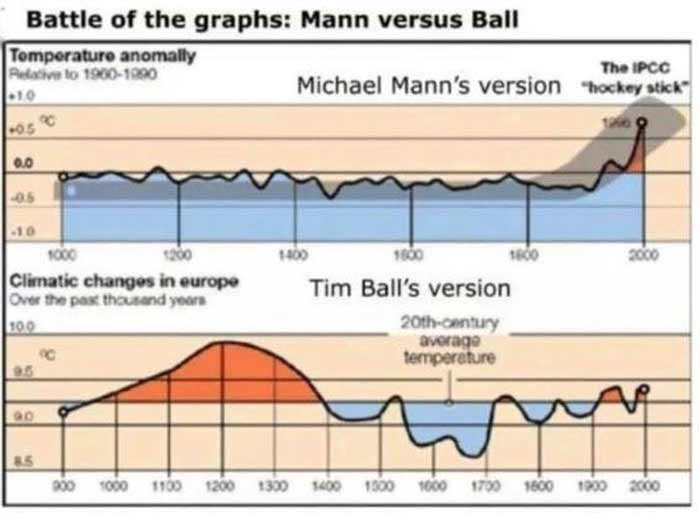

Pour illustrer les erreurs développées dans les premiers rapports AR1-2-3 du GIEC, il convient d’évoquer l’affaire du graphe en « crosse de hockey » ou « courbe de Mann » (MBH98 et MBH99) proposé en 1998, par Michael E. Mann et ses co-auteurs, Raymond S. Bradley et Malcolm K. Hughes [MBH]. Ce graphe se veut décrire l’évolution des températures de la planète durant les 1000 dernières années19. La « crosse de hockey » présente une température stable de l’an 1000 jusqu’à 1950, suivie par une élévation brutale et d’allure catastrophique de 1950 à 2000. C’est parfaitement conforme au « dogme climatique » qui, précisément, prétend lutter contre le réchauffement brutal des températures prédit par Roger Revelle en 1957. D’un point de vue factuel, la « courbe de Mann » a stimulé la volonté des autorités américaines, d’intervenir pour contrer la catastrophe climatique qui surviendrait si l’élévation des températures se poursuivait, au-delà des années 2000, en suivant la partie droite de la « crosse de hockey ». Il s’avère que la courbe de Mann est grossièrement fausse, et basée sur des erreurs statistiques importantes. Ceci a été amplement démontré en 2006 par le « Rapport Wegman »20 et d’autres études similaires.

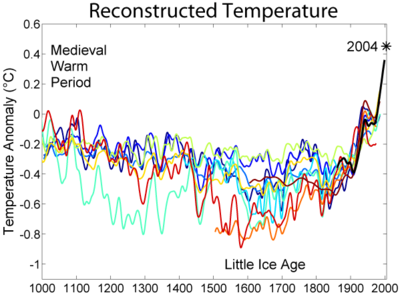

La courbe de Mann ignore tout particulièrement le « petit âge glaciaire » (little ice age) de 1600 à 1900, ainsi que « l’optimum médiéval » (medieval warm period) de 900 à 1300. Ces fluctuations sont visibles dans le graphe amélioré ci-dessous. Pour mémoire, l’optimum médiéval est une période de températures élevées observées au moyen-âge, et attestée historiquement par quantité de témoignages (colonisation du Groenland, culture de la vigne en Norvège…). À l’inverse, le petit âge glaciaire a été caractérisé par des températures très froides durant tout le XVIIIe siècle, où la Seine gelait régulièrement. On estime que les fluctuations de température moyenne associées à ces périodes sont de l’ordre de 1 °C. On imagine sans peine l’impact qu’aurait eu une baisse de température voisine de 5 °C, si les prévisions du climatologue britannique Hubert Lamb avaient été exactes (voir plus haut).

On comprend l’énergie développée par les tenants de la religion du climat pour valider la courbe de Mann ». En effet, les fluctuations de température de l’optimum médiéval et du petit âge glaciaire se sont produites en dehors de toute production industrielle de CO2 ! Si on admet leur existence, on contredit l’affirmation, répétée à l’envi dans les rapports du GIEC, que le réchauffement observé dans l’ère industrielle est sans précédent.

La température était véritablement glaciaire durant le XVIIIe siècle ; pour en témoigner, on mentionne souvent la charge des hussards du général Pichegru, qui prit d’assaut le 21 janvier 1795 la flotte hollandaise immobilisée dans la mer gelée. On admettra sans peine qu’il fallait une sérieuse baisse des températures par rapport à la moyenne pour faire en sorte que la mer gèle aux Pays-Bas, sur une épaisseur suffisante pour supporter une charge de cavalerie. Or, sur la courbe en crosse de hockey, on ne voit rien !

La polémique autour des travaux de Mann, Bradley et Hugues a culminé avec la querelle qu’ils ont eue avec le climatologue canadien Timothy (Tim) Ball. Ce dernier avait élaboré un graphe de températures donnant la part belle à l’optimum médiéval, et montrant, en particulier que l’élévation des températures postérieure à 1950 était négligeable par rapport aux variations de la période médiévale. Mann a poursuivi Tim Ball en justice et a perdu son procès en 2019, étant incapable de produire les données à partir desquelles il avait fabriqué son graphe en forme de crosse de hockey.

Il ressort de ces développements que la création du GIEC, comme ses premiers travaux, reposant sur la « courbe de Mann », ont été basés sur des interprétations inexactes de données mal documentées. En particulier, l’affirmation que le réchauffement climatique observé depuis 1950 est « sans précédent » est loin d’exprimer une vérité admise par le plus grand nombre de climatologues.

Dans ses rapports AR1-6, le GIEC a développé une théorie visant à montrer que la concentration de gaz carbonique (CO2) dans l’atmosphère était le facteur explicatif principal de l’évolution des températures. À l’appui de ces affirmations se trouve la concomitance des variations du taux atmosphérique de CO2 et des températures.

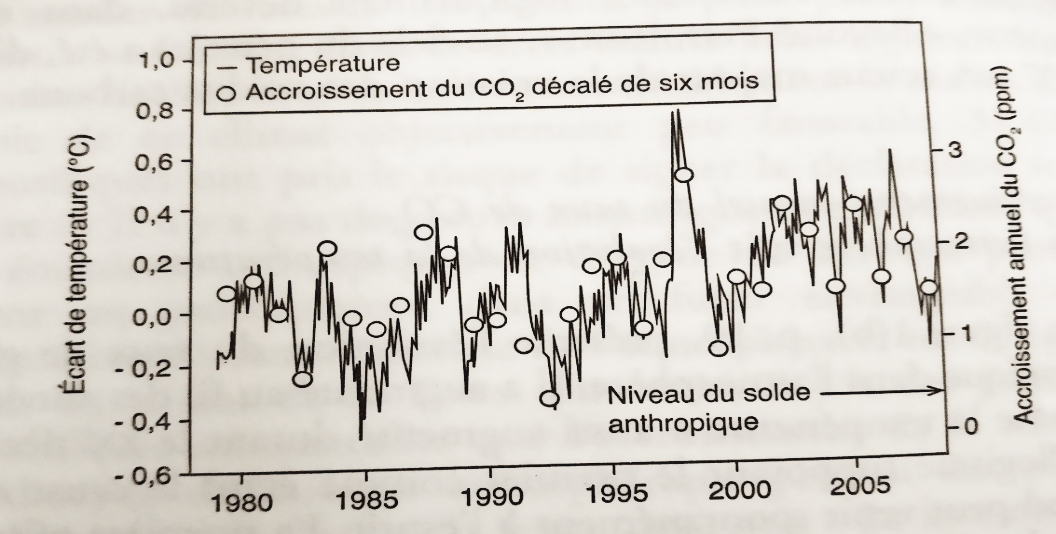

En fait, il faut être prudent dans l’affirmation qu’il existe une causalité entre le taux atmosphérique du CO2 (à l’instant t) et la température (au même instant t). Lorsqu’on observe des concomitances entre deux chroniques temporelles, cela ne signifie pas pour autant que la variation de l’une influe sur l’autre. Le graphe ci-dessous, dû à François Gervais21 compare, pour la période 1980— 2005, la température moyenne T(t) (trait continu) terrestre à chaque instant t (sur une échelle annuelle), à la variation annuelle ϑ(t) – ϑ(t-1) du taux ϑ(t) de CO2, décalée de 6 mois, soit ϑ(t+1/2) – ϑ(t-1/2). Avec un choix d’échelle convenable pour T(.) et ϑ(.), on constate que les courbes se superposent. On en déduit que le taux de CO2 mesuré aux instants t+1/2 = t+6 mois et t-1/2 = t-6 mois semble lié à la température à l’instant t. Mais, si tel est bien le cas, c’est la température à l’instant t qui influe sur le taux de CO2 à l’instant t+1/2, et non l’inverse !

Ceci veut dire, si ce raisonnement était correct, que la variation des températures (par des mécanismes naturels) provoquerait la variation du CO2 (et non l’inverse)22. De ce fait, toute la construction du GIEC s’effondrerait. Toutefois, il faut distinguer les variations du taux de CO2 issues de phénomènes naturels, qui pourraient très bien se déduire des variations de la température, des variations de CO2 d’origine anthropique, qui elles, ne dépendent que de l’activité humaine. Il faut retenir de ceci que la réalité des dépendances entre le CO2 et la température est plus complexe que ne laissent entendre les modèles du GIEC.

/image%2F0994625%2F20240222%2Fob_8cb950_religion-climat.webp)

/https%3A%2F%2Flh3.googleusercontent.com%2Fblogger_img_proxy%2FAJ0KDdWjEZ9D3bKwEJrLMKXNgQ-ko7kJFqCcdRNjnqWVnPlUq9ey5KxN8gnTPrcYKfbFhCIGgX71P_1xS1CtJtE5wratVYPUE6cmmcO97lqfk9B5BWfbtyfTdK_aznXs5zucFZo9bM-FXagMDO74%3Dw1200-h630-p-k-no-nu)